- · 《保健文汇》栏目设置[06/29]

- · 《保健文汇》投稿方式[06/29]

- · 《保健文汇》征稿要求[06/29]

- · 《保健文汇》刊物宗旨[06/29]

智源研究院发布超大规模新型预训练模型“悟道

作者:网站采编关键词:

摘要:来源:人民网-科技频道 2021年1月11日,北京智源人工智能研究院发布面向认知的超大规模新型预训练模型“文汇”,旨在探索解决当前大规模自监督预训练模型不具有认知能力的问题,

来源:人民网-科技频道

2021年1月11日,北京智源人工智能研究院发布面向认知的超大规模新型预训练模型“文汇”,旨在探索解决当前大规模自监督预训练模型不具有认知能力的问题,这一项目由智源研究院发起的“悟道”攻关团队完成。

“文汇”模型不仅使用数据驱动的方法来建构预训练模型,还将用户行为、常识知识以及认知联系起来,主动“学习”与创造。本次发布的“文汇”模型与1月初OpenAI刚刚发布的DALL·E和CLIP这两个连接文本与图像的大规模预训练模型类似,“文汇”模型能够学习不同模态(文本和视觉领域为主)之间的概念,可以实现“用图生文”等任务,具有一定的认知能力。“文汇”模型参数规模达113亿,仅次于DALL·E模型的120亿参数量,是目前我国规模最大的预训练模型,并已实现与国际领先预训练技术的并跑。

智源研究院学术副院长、清华大学计算机系唐杰教授认为,GPT-3等超大型预训练模型在处理复杂的认知推理任务上,例如开放对话、基于知识的问答、可控文本生成等,结果仍然与人类智能有较大差距。智源研究院院长、北京大学信息技术学院黄铁军教授指出,“文汇”模型针对性地设计了多任务预训练的方法,可以同时学习文→文、图→文以及图文→文等多项任务,实现对多个不同模态的概念理解。经过预训练的“文汇”模型不需要进行微调就可以完成“用图生文”等任务,对模型进行微调则可以灵活地接入如视觉问答、视觉推理等任务。

“文汇”模型应用即将上线

目前,“文汇”已支持基于认知推理的多种自然语言及跨模态应用任务,部分应用即将与搜狗、阿里巴巴、学堂在线、智谱.AI、循环智能等机构合作上线。目前已有四个样例应用可用于展示模型效果。

(一)基于上传图片的开放域问答

本应用基于图片文本的多模态认知预训练百亿模型,可以支持用户上传图片后,针对图片内容进行提问或生成图片的一句话描述。如上传图片后询问“图片中的电脑在水杯的什么位置?”或“生成对应商品图片的一句话描述”。将于未来大规模应用于阿里的电商场景。

(二)Talk to Data,用语言操作数据可视化

本应用基于数据可视化技术,通过将自然语言转化为可视化查询语句,从而达到“上传图表,输入指令,输出可视化图像”的功能目标。只需要一句自然语言的话,就可以实现数据的可视化自动统计与查询。

(三)基于预训练语言模型的诗词创作应用

本应用可以基于输入的诗歌题目、朝代、作者,生成仿古诗词。与传统基于规则或监督学习的诗歌生成不同,这个应用创作的诗歌来自于自然语言的生成,且无标注数据进行fine-tune,并且可以模仿任意诗人创作任意新颖题目的诗歌。

下面是基于模型自动作诗的结果:

赠抗疫英雄

君王歌里赠英雄,百万雄师劈毒烟。

况是人民勤努力,更加众志与国捐。

团结团结再团结,万众一心战瘟神。

沔水桥边香雾起,暗送瘟神过汉阳。

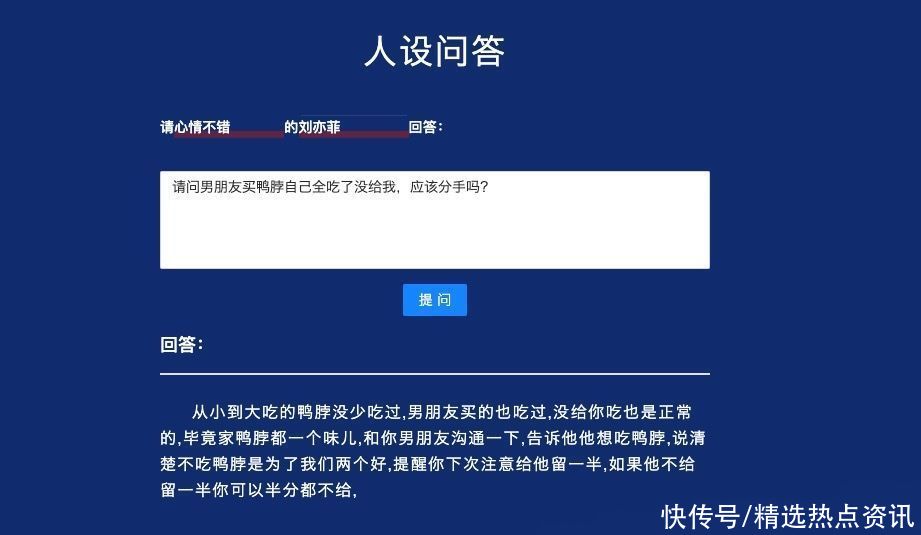

(四)可控人设的开放域问答

本应用支持用户上传问题,并生成具有人物角色风格的定制化文本回答。与传统的开放式问答不同,“文汇”模型生成的答案具有人设的语言特色,问答内容趣味横生。目前该应用将计划在搜狗的问答场景中使用。

“悟道”项目下一步研发计划

目前,“悟道”项目研究团队正在视觉等更广泛的范围内,对大规模自监督预训练方法开展探索研究,已经启动了四类大规模预训练模型研制,包括“文源”(以中文为核心的超大规模预训练语言模型)、“文汇”(面向认知的超大规模新型预训练模型)、“文澜”(超大规模多模态预训练模型)和“文溯”(超大规模蛋白质序列预训练模型)。2020年11月14日,智源研究院已发布了“文源”(以中文为核心的超大规模预训练语言模型)第一阶段26亿参数规模的中文语言模型。下一步,智源研究院将联合优势单位加快四类大规模预训练模型的研发进度。特别是“文汇”模型,未来将着力在多语言、多模态条件下,提升完成开放对话、基于知识的问答、可控文本生成等复杂认知推理任务的能力,使其更加接近人类水平。计划在今年6月实现“中文自然语言应用系统”“基于图文增强和知识融入的图文应用系统”“基于认知的复杂认知系统”等一批各具特色的超大规模预训练模型,以期达到对国际领先AI技术的赶超,尽快实现我国在国际AI前沿技术研究的领跑。

文章来源:《保健文汇》 网址: http://www.bjwhzzs.cn/zonghexinwen/2021/0213/553.html